Я буду отключать диски, и наблюдать, как поведёт себя ASM и база данных, а также данная статья призвана пролить свет на количественные характеристики показателей свободного, занятого, и прочего места в ASM, при проведение эксперимента и ответить на вопрос ‘а что если..?’.

Версия ASM 12.1.0.2.190716

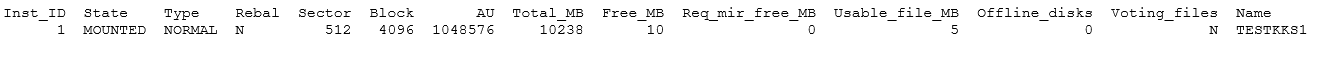

Конфигурация: Дисковая группа из шести дисков и двух Failgroup, по 3 диска в каждой FG, с избыточностью Normal.

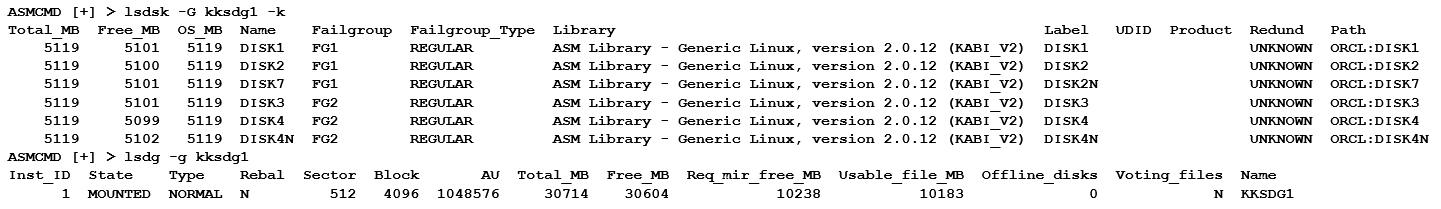

SQL> create diskgroup kksdg1 normal redundancy failgroup fg1 disk 'ORCL:DISK1','ORCL:DISK2','ORCL: DISK7' failgroup fg2 disk 'ORCL:DISK3','ORCL:DISK4','ORCL:DISK4N';

Diskgroup created.

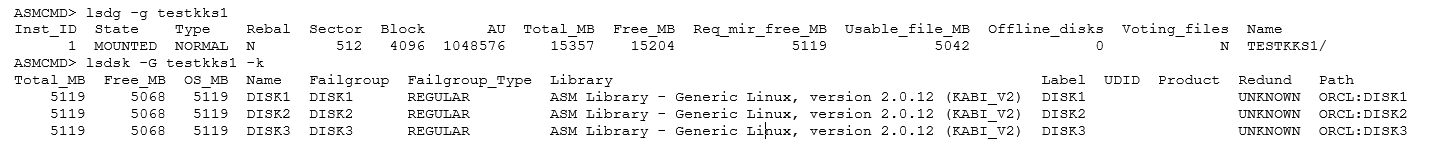

Req_mir_free_MB — зарезервировал по одному диску на каждую failgroup, и того зарезервировано 2 диска.

Расчет: Usable_file_MB =( Free_MB — Req_mir_free_MB )/2= 10 183

1.1 Заполним дисковую группу:

SQL> create tablespace kkstbs1 datafile '+kksdg1' size 7168M;

Tablespace created.

Elapsed: 00:00:16.42

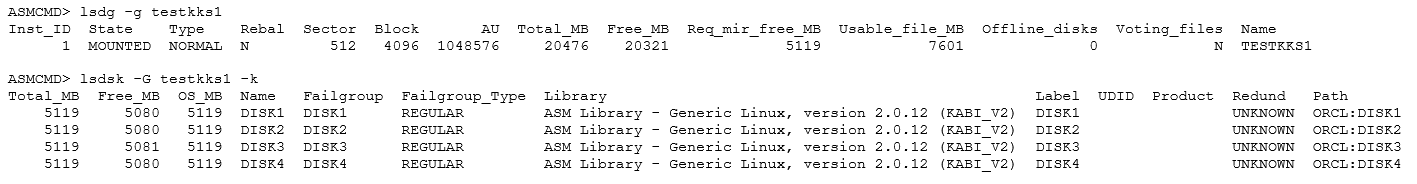

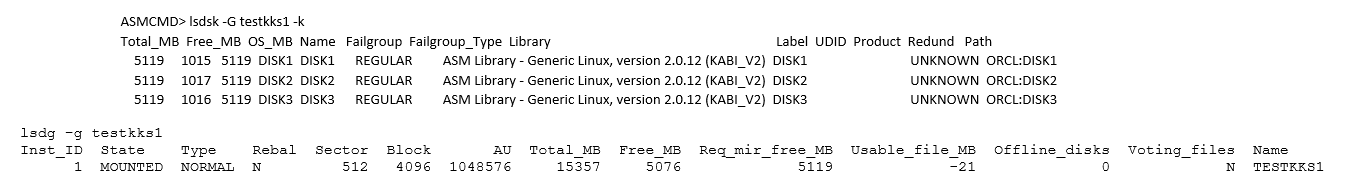

Взглянем на дисковую группу:

Все диски в дисковой группе заполнились равномерно(внимание на колонку Free_MB).

1.2 Проверим устойчивость дисковой группы к выходу из строя дисков:

Я выставил ‘DISK_REPAIR_TIME’=’1m’ для дисковой группы.

1.2.1 Отключаем первый диск(DISK1):

[root@kks grid12]# oracleasm querydisk -d DISK1

Disk "DISK1" is a valid ASM disk on device [8,81]

[root@kks grid12]# ls -l /dev/* | grep 8, | grep 81

brw-rw---- 1 root disk 8, 81 Aug 5 15:56 /dev/sdf1

[root@kks grid12]# echo 1 > /sys/block/sdf/device/delete

ASM Alert log:

Wed Aug 05 16:24:36 2020

Errors in file /grid/app/diag/asm/+asm/+ASM/trace/+ASM_gmon_2966.trc:

ORA-15186: ASMLIB error function = [kfk_asm_ioerror], error = [0], mesg = [I/O Error]

Wed Aug 05 16:24:36 2020

NOTE: PST update grp = 2 completed successfully

Wed Aug 05 16:25:22 2020

WARNING: Started Drop Disk Timeout for Disk 0 (DISK1) in group 2 with a value 60

WARNING: Disk 0 (DISK1) in group 2 will be dropped in: (60) secs on ASM inst 1

DB Alert log:

Wed Aug 05 16:24:36 2020

NOTE: updating disk modes to 0x5 from 0x7 for disk 0 (DISK1) in group 2 (KKSDG1): lflags 0x0

NOTE: disk 0 (DISK1) in group 2 (KKSDG1) is offline for reads

NOTE: updating disk modes to 0x1 from 0x5 for disk 0 (DISK1) in group 2 (KKSDG1): lflags 0x0

NOTE: disk 0 (DISK1) in group 2 (KKSDG1) is offline for writes

ASM Alert log:

Wed Aug 05 16:28:29 2020

SUCCESS: alter diskgroup KKSDG1 drop disk DISK1 force /* ASM SERVER */

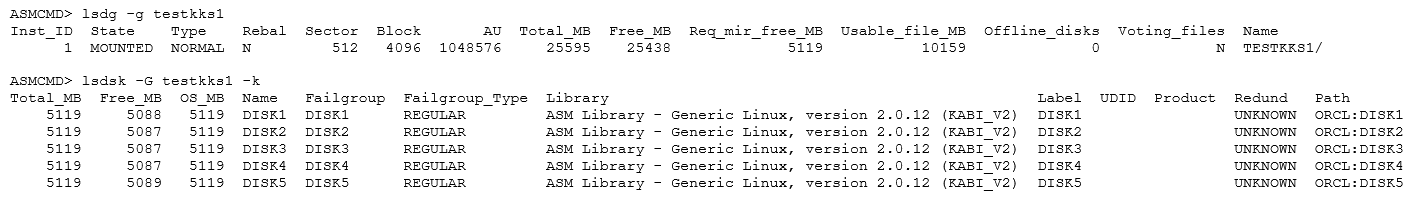

По прошествии нескольких минут диск был удалён, ребаланс прошел успешно.

1.2.2 Отключаем второй диск(DISK2):

[root@kks grid12]# oracleasm querydisk -d DISK2

Disk "DISK2" is a valid ASM disk on device [8,129]

[root@kks grid12]# ls -l /dev/* | grep 8, | grep 129

brw-rw---- 1 root disk 8, 129 Aug 5 15:56 /dev/sdi1

[root@kks grid12]# echo 1 > /sys/block/sdi/device/delete

ASM Alert log:

Wed Aug 05 16:34:44 2020

WARNING: Started Drop Disk Timeout for Disk 1 (DISK2) in group 2 with a value 60

WARNING: Disk 1 (DISK2) in group 2 will be dropped in: (60) secs on ASM inst 1

Errors in file /grid/app/diag/asm/+asm/+ASM/trace/+ASM_gmon_2966.trc:

ORA-15186: ASMLIB error function = [kfk_asm_ioerror], error = [0], mesg = [I/O Error]

…………………………………..

Wed Aug 05 16:37:51 2020

SUCCESS: alter diskgroup KKSDG1 drop disk DISK2 force /* ASM SERVER */

DB Alert log:

Wed Aug 05 16:32:47 2020

NOTE: updating disk modes to 0x5 from 0x7 for disk 1 (DISK2) in group 2 (KKSDG1): lflags 0x0

NOTE: disk 1 (DISK2) in group 2 (KKSDG1) is offline for reads

NOTE: updating disk modes to 0x1 from 0x5 for disk 1 (DISK2) in group 2 (KKSDG1): lflags 0x0

NOTE: disk 1 (DISK2) in group 2 (KKSDG1) is offline for writes

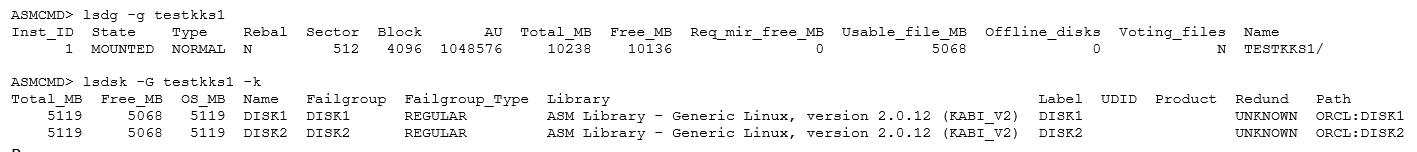

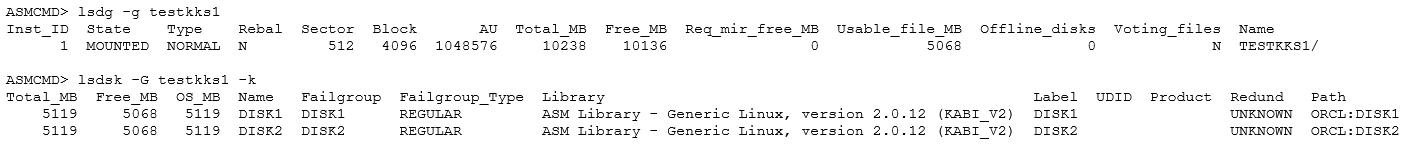

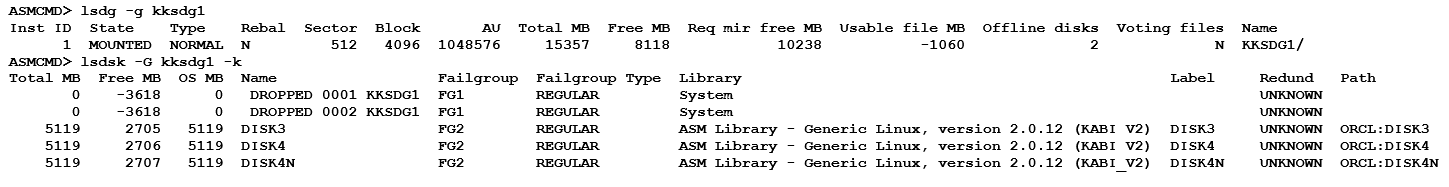

На данном этапе получилось, что ребаланc завешается ошибкой ORA-15041, недостаточно места в дисковой группе и в FG1 в частности, чтобы провести ребаланс.

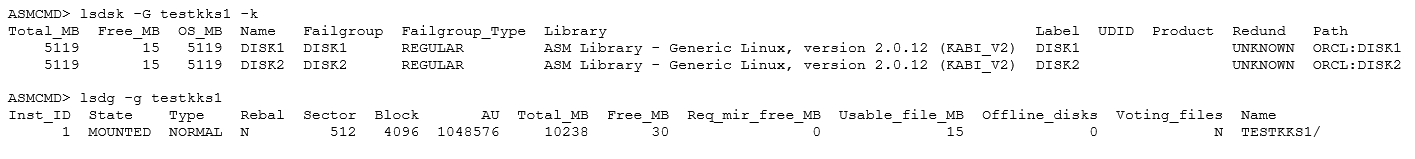

Данный диск _DROPPED_0001_KKSDG1 не удаляется, а переименовался, бд по-прежнему доступна и таблицы в табличном пространстве kkstbs1 тоже живы, также Usable_file_MB в минусе.

В Alert log BD:

Wed Aug 05 16:37:51 2020

SUCCESS: disk DISK2 (1.3916017828) renamed to _DROPPED_0001_KKSDG1 in diskgroup KKSDG

1.2.3 Отключаем третий диск(DISK7):

[root@kks grid12]# oracleasm querydisk -d DISK7

Disk "DISK2" is a valid ASM disk on device [8, 161]

[root@kks ~]# ls -l /dev/* | grep 8, | grep 161

brw-rw---- 1 root disk 8, 161 Aug 6 13:17 /dev/sdk1

[root@kks ~]# echo 1 > /sys/block/sdk/device/delete

Остановим бд и перемонтируем дисковую группу, проверим, не потеряю ли я группу на данном этапе:

SQL> alter diskgroup kksdg1 dismount;

Diskgroup altered.

SQL> alter diskgroup kksdg1 mount;

Diskgroup altered.

Может показаться, что если невозможно провести ребаланс, по причине ошибки ORA-15041, ASM не удалят диски, а переименовывает их.

Но это только показалось, в ходе эксперимента было десятки кейсов удаления дисков, и поведение может отличаться. Например, если удалить, созданное на этой дисковой группе табличное пространство kkstbs1, то произойдёт это:

SUCCESS: grp 2 disk _DROPPED_0000_KKSDG1 going offline

SUCCESS: grp 2 disk _DROPPED_0001_KKSDG1 going offline

NOTE: Disk _DROPPED_0000_KKSDG1 in mode 0x0 marked for de-assignment

NOTE: Disk _DROPPED_0001_KKSDG1 in mode 0x0 marked for de-assignment

диски удалятся, но последующие несколько экспериментов показали, что это не всегда так.

Какой в этом смысл? Зачем держать эти диски, которых фактически нет.

Также, если удалять дисковую группу через drop diskgroup force including contents, то повторное использование дисков не требует зачистки их заголовков через dd, если использовать просто drop diskgroup, то нужно чистить заголовок диска, чтобы его повторно использовать(это особенность asm 12), force можно применить если группа не замонтирована.

И на сладкое, двойное удаление дисковой группы(тест на то, что заголовки дисков живы после удаления группы):

SQL> drop diskgroup kksdg1 force including contents;

drop diskgroup kksdg1 force including contents

*

ERROR at line 1:

ORA-15039: diskgroup not dropped

ORA-15230: diskgroup 'KKSDG1' does not require the FORCE option

SQL> drop diskgroup kksdg1;

Diskgroup dropped.

SQL> drop diskgroup kksdg1 force including contents;

drop diskgroup kksdg1 force including contents

*

ERROR at line 1:

ORA-15039: diskgroup not dropped

ORA-15063: ASM discovered an insufficient number of disks for diskgroup

"KKSDG1"

SQL> alter diskgroup kksdg1 mount;

alter diskgroup kksdg1 mount

*

ERROR at line 1:

ORA-15032: not all alterations performed

ORA-15017: diskgroup "KKSDG1" cannot be mounted

ORA-15040: diskgroup is incomplete

SQL> drop diskgroup kksdg1 force including contents; <----- Здесь я вернул отключенные диски(просканировав шину SCSI ) и смогу удалить дисковую группу ещё раз 0_о

Diskgroup dropped.

SQL>

Вероятно будет часть 3 и версия asm 19, с применением утилит ASM tools used by Support : KFOD, KFED, AMDU (Doc ID 1485597.1), т.к. как всегда(у меня), вопросов больше, чем ответов.